YOLOv5 🚀 是一系列在 COCO 数据集上预训练的对象检测架构和模型,代表 Ultralytics 对未来视觉 AI 方法的开源研究,结合了在数千小时的研究和开发中获得的经验教训和最佳实践。

安装

Python>=3.6.0 ,需要安装所有 requirements.txt,包括 PyTorch>=1.7:

$ git clone https://github.com/ultralytics/yolov5

$ cd yolov5

$ pip install -r requirements.txt

使用

使用 YOLOv5 和 PyTorch Hub 进行推理。 模型会自动从最新的 YOLOv5 版本下载。

import torch

# Model

model = torch.hub.load('ultralytics/yolov5', 'yolov5s') # or yolov5m, yolov5x, custom

# Images

img = 'https://ultralytics.com/images/zidane.jpg' # or file, PIL, OpenCV, numpy, multiple

# Inference

results = model(img)

# Results

results.print() # or .show(), .save(), .crop(), .pandas(), etc.

使用 detect.py

detect.py 自动下载最近新的 YOLO5 模型,保存检测的结果到 runs/detect。

$ python detect.py --source 0 # webcam

file.jpg # image

file.mp4 # video

path/ # directory

path/*.jpg # glob

'https://youtu.be/NUsoVlDFqZg' # YouTube video

'rtsp://example.com/media.mp4' # RTSP, RTMP, HTTP stream

训练

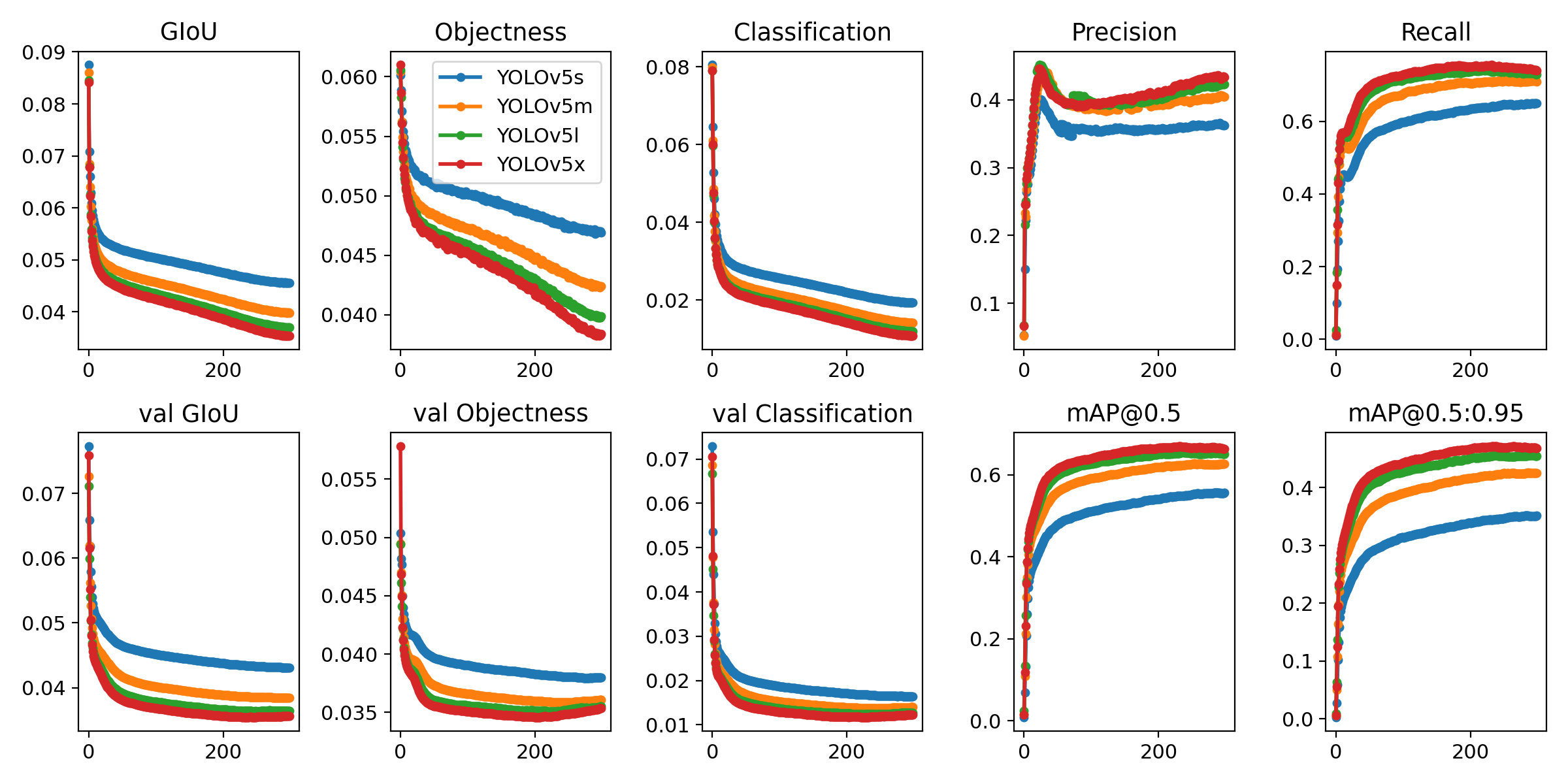

运行以下命令以在 COCO 数据集上重现结果(首次使用时数据集自动下载)。 在单个 V100 上,YOLOv5s/m/l/x 的训练时间为 2/4/6/8 天(多 GPU 速度更快)。

$ python train.py --data coco.yaml --cfg yolov5s.yaml --weights '' --batch-size 64

yolov5m 40

yolov5l 24

yolov5x 16

运行环境

在几秒钟内开始使用经过验证的环境和集成,包括用于自动 YOLOv5 实验记录的权重和偏差。 单击下面的每个图标了解详细信息。

Docker 环境:https://hub.docker.com/r/ultralytics/yolov5

colab: https://colab.research.google.com/github/ultralytics/yolov5/blob/master/tutorial.ipynb

未经允许不得转载:PythonOK » YOLOv5 6 行代码实现目标检测

PythonOK

PythonOK Yolov5_DeepSort_Pytorch:基于 Yolov5 + Deep Sort 的实时多目标跟踪器

Yolov5_DeepSort_Pytorch:基于 Yolov5 + Deep Sort 的实时多目标跟踪器 CMU 开源 OpenPose 实时多人关键点检测库,可以Windows直接安装体验

CMU 开源 OpenPose 实时多人关键点检测库,可以Windows直接安装体验 人脸打分|基于卷积神经网络 TensorFlow 框架

人脸打分|基于卷积神经网络 TensorFlow 框架 你好,这里有一份2019年目标检测指南

你好,这里有一份2019年目标检测指南 十个python图像处理工具

十个python图像处理工具